Работа с нестабильными автотестами

Вы можете помечать автотесты в системе как нестабильные, чтобы анализировать стабильность ваших автотестов. Отметить автотест как нестабильный (flaky) можно:

- В пользовательском интерфейсе Test IT

- Автоматически (необходимо произвести настройки)

- С помощью API

Идентификация нестабильных автотестов

Test IT позволяет идентифицировать нестабильные тесты с помощью статистики запусков. По умолчанию система отслеживает историю запусков и формирует статистику по последним 100 запускам автотеста. Частота прохождений с разными результатами влияет на процент стабильности автотеста. Стабильным считается автотест, который за последние 100 запусков дает один и тот же результат.

Чтобы идентифицировать нестабильный автотест:

- Откройте проект.

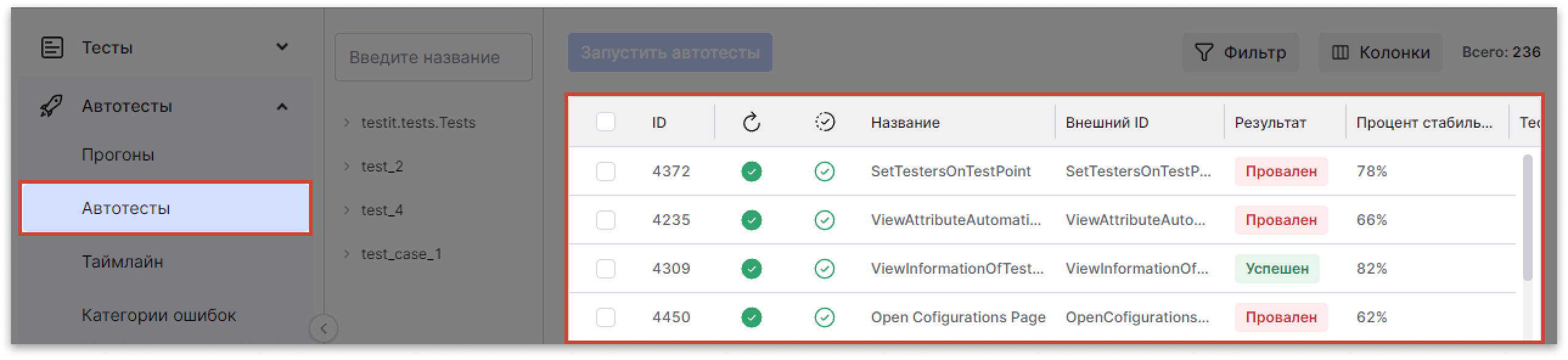

- Перейдите в раздел Автотестирование → Библиотека автотестов.

- Откройте карточку автотеста.

- Проверьте поле Стабильность прохождения в описании автотеста. Если стабильность теста менее 100%, вы можете пометить тест как нестабильный.

Вы можете проанализировать ошибки нестабильных автотестов и создать категории ошибок, чтобы система находила их автоматически.

Проставление отметки о нестабильности через UI

Проставление отметки о нестабильности для одного автотеста

- Откройте проект.

- Перейдите в раздел Автотестирование → Библиотека автотестов.

- Откройте карточку автотеста.

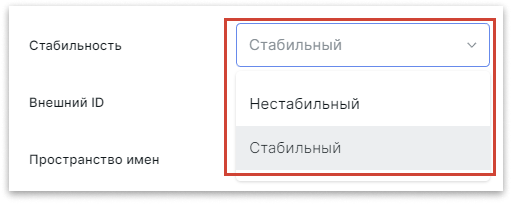

- В описании автотеста найдите поле Стабильность и выберите статус в выпадающем меню.

Проставление отметки о нестабильности для нескольких автотестов

- Откройте проект.

- Перейдите в раздел Автотестирование → Библиотека автотестов.

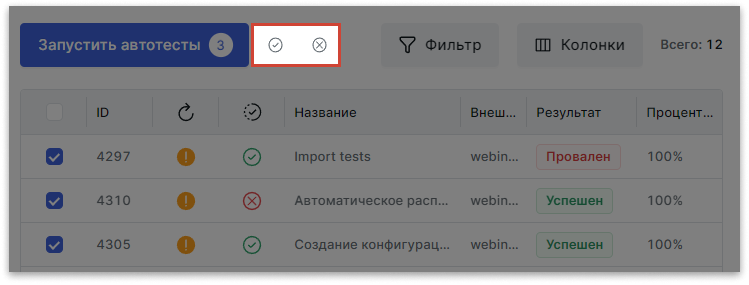

- Отметьте автотесты, которым хотите поставить отметку о нестабильности.

- Над списком автотестов нажмите Отметить автотест как нестабильный, для этого нажмите значок

.

. - Опционально: Отметьте тест как стабильный, для этого нажмите значок

.

.

- Опционально: Отметьте тест как стабильный, для этого нажмите значок

Смотрите также: Массовые действия с автотестами.

Смотрите также: Массовые действия с автотестами.

Автоматическая отметка нестабильных автотестов

![]() Опция Standard и Enterprise

Опция Standard и Enterprise

Эта опция доступна в тарифах Standard и Enterprise. В тариф Lite она не входит.

Подробнее: о тарифах Test IT.

Test IT может автоматически отмечать тесты как нестабильные. Для этого нужно включить соответствующую опцию в настройках проекта (по умолчанию отключена).

Как рассчитывается стабильность автотестов

Стабильность рассчитывается как отношение количества изменений результатов к их общему количеству за последние 100 прогонов. В подсчете стабильности участвуют результаты Успешен, Провален, Пропущен и Заблокирован. Подсчет начинается со второго результата, первый результат не учитывается.

Стабильность теста не означает его успешность. Например, последние 100 прогонов Тест 1 прошел с результатом Успешен, а Тест 2 — с результатом Провален. Стабильность обоих тестов составит 100%.

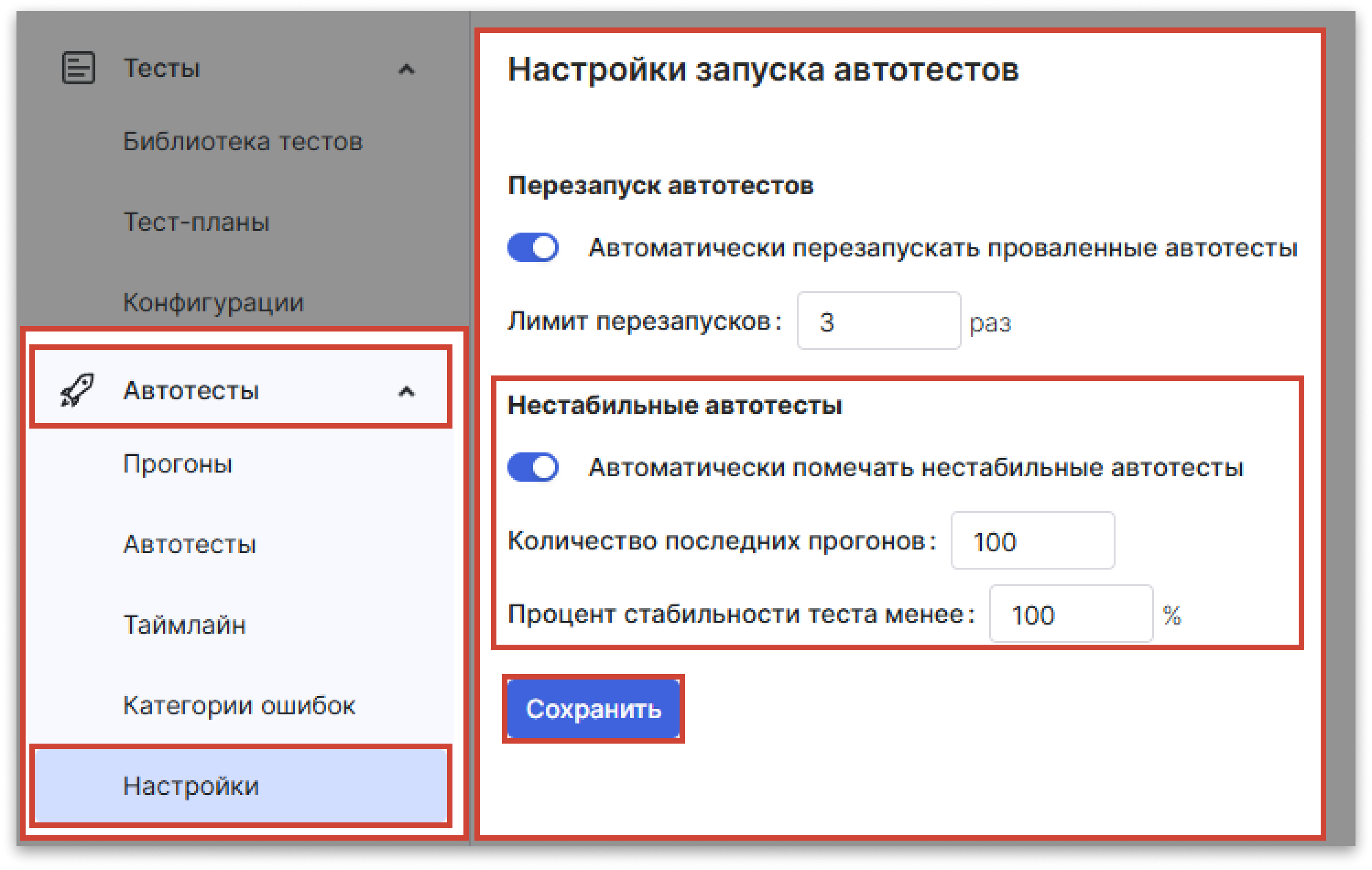

Чтобы включить и настроить автоматическую отметку нестабильных автотестов:

- Откройте проект.

- В навигационном меню слева откройте раздел Автотестирование → Настройка запуска.

- Включите опцию Автоматически помечать нестабильные автотесты.

- Укажите количество последних прогонов и процент стабильности автотестов. На основании этих данных система будет определять нестабильные автотесты.

- Нажмите Сохранить.

Проставление отметки о нестабильности через API

Чтобы отметить тесты как нестабильные с помощью API:

- При создании автотеста с помощью метода

POST /api/v2/falky/bulkукажите значение параметраisFlakyкакtrue.

Автотест, созданный в системе, будет автоматически отмечен как нестабильный.